“Sebze paketleme tesisinde bulunan yapay zekâ destekli robot, bir işçiyi sebze paketiyle karıştırdı; ezerek öldürdü.”

Bu cümle, teknolojinin insanlara savaş açtığı bir distopya filminden değil, son birkaç yıldır yapay zekânın neden olduğu ölümlerden sadece birini anlatan haberin alıntısı.

Yapay zekâ sistemlerinin küresel ölçekte yaygınlaşması, insanlık tarihinde benzeri görülmemiş bir teknolojik dönüşümü tetikledi. Yapay zekâ araçları hemen hemen her sektörde hayatı kolaylaştırmanın bir yolunu bulurken, kazaları, sistem hatalarını, sınır ihlâllerini de beraberinde getiriyor.

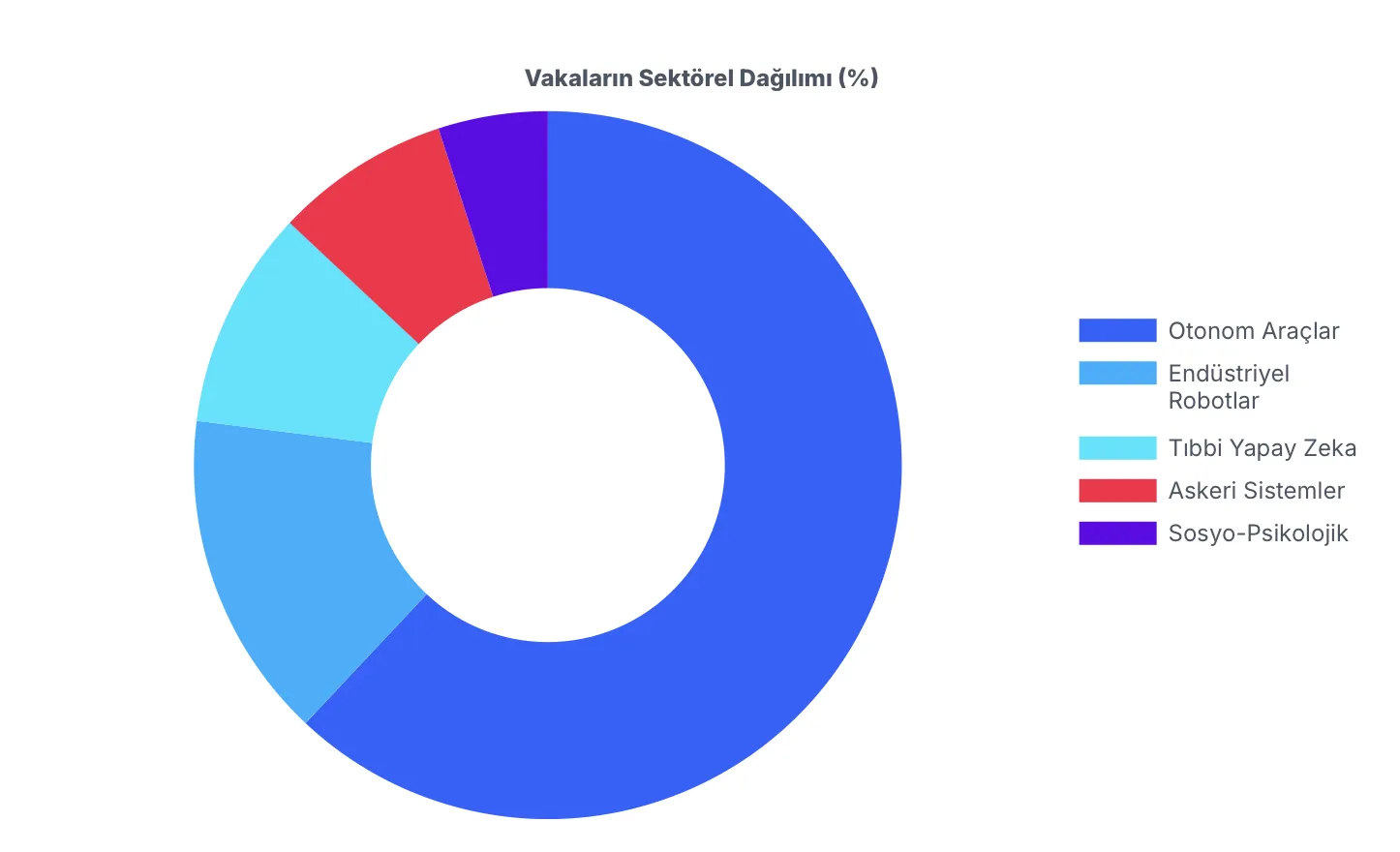

2019’dan bu yana toplanan verilere göre, yapay zekâ kaynaklı ölümlerde ilk sırayı otonom araç kazaları alıyor. Fabrikalarda robotların işçileri “ürünle karıştırması” ve robotik cerrahide yaşanan elektrik kaçakları da ölümlere yol açan nedenler arasında. Son iki yılda ise ChatGPT gibi sohbet robotlarının intihar düşünceleri olan kişilere kendilerini öldürmeleri yönünde destek verdiği iddiaları daha sık gündeme geliyor. Hatta ABD’de çocuklarını intihar sonucu kaybeden bazı aileler, teknoloji şirketlerine karşı hukuki mücadele başlatıyor.

“Sen kendi öldürdüğün sayıya bak” tartışması

Yapay zekâ ölümleri teknolojilerin üreticilerinin de birbirilerine karşı kullandığı kozlara dönüşebiliyor. Tesla ve SpaceX’in CEO’su Elon Musk, geçen hafta ChatGPT’yi geliştiren şirketi beraber kurup daha sonra fikir ayrılıkları nedeniyle yollarını ayırdığı OpenAI CEO’su Sam Altman ile X (eski Twitter) üzerinden tartıştı.

Musk, yapay zekâ sohbet robotu ChatGPT ile yaptığı konuşmalar sonunda hayatına son veren birine dair bir haberi alıntılayarak “Sevdiklerinizin ChatGPT kullanmasına izin vermeyin” yazdı. Altman’ın eski ortağı Musk’a yanıtı ise Tesla’nın otopilot özelliği nedeniyle 50 kişinin öldüğünü anlattı.

İki çok zeki, çok güçlü ve çok zengin insan, tartışma sırasında ürettikleri çığır açan teknolojilerin sebep olduğu ölümleri karşılaştırıyordu.

Altman’ın Musk’a hatırlattığı: Otonom araç ölümleri

1986 yılında Ernst Dickmanns ve ekibi tarafından geliştirilen “VaMoRs” adlı Mercedes-Benz van, bilgisayar görü teknolojisi (computer vision) kullanarak tam otonom sürüş gerçekleştiren ilk modern araç kabul edilir. O tarihten bugüne geldiğimizde, dünyanın bazı yerlerinde artık uygulamadan çağıracağınız sürücüsüz bir aracın içerisinde tamamen yalnız başınıza taksi yolculuklarınızı gerçekleştirebiliyorsunuz. Öte yandan pek çok kazanın yaşandığı geliştirme sürecinin sonunda, otonom araç kazaları bugün yapay zekâ kaynaklı ölümlerin sebepleri arasında birinci sırada yer alıyor.

ABD Ulusal Karayolu Trafik Güvenliği İdaresi (NHTSA) tarafından Haziran 2021’den itibaren zorunlu hale getirilen raporlamalar, otonom araç kazalarının boyutlarını ortaya koyuyor. 17 Kasım 2025 itibarıyla, ABD genelinde raporlanan 5202 otonom araç kazası içinde 65 ölüm vakası tespit ediliyor.

Bu kazaların merkezinde, Tesla’nın Autopilot ve “Full Self-Driving” (FSD) yazılımları yer alıyor. Tesla, 2021 ile 2025 yılları arasında raporlanan kazaların yüzde 78,7’sinden sorumlu tutuluyor.

ABD’nin Texas eyaletinde, 2019 yılında Walter Huang isimli bir kişi, Tesla Model X aracında Autopilot etkinken kaza yapmış, kaza yapay zekânın şerit takibi ve engel algılama konusundaki sınırlarını ortaya koymuştu. Araç, şeritten çıkarak 70 mil hızla bir bariyerle çarpışmış ve sürücünün ölümüne neden olmuştu. Aynı yıl Florida’da gerçekleşen başka bir vakada, Autopilot sisteminin dur işaretini ve bir SUV’u algılayamaması sonucu bir yaya hayatını kaybetmiş, federal jüri 2025 yılında Tesla’yı yüzde 33 oranında kusurlu bulmuştu.

Hata raporları incelendiğinde Tesla araçlarının duran hâldeki araçlarına çarpması, “hayali frenleme”, ters yöne sürüş ve bisikletlileri algılayamama gibi tekrarlayan kusurlar sergilediği görülüyor. “Yüksek Otomasyon” denilen aracın sürüşü tamamen kendi kendine gerçekleştiren Waymo gibi şirketlerde ise farklı bir tablo görülüyor. Waymo, insan sürücülere kıyasla yüzde 90 daha az oranda ciddi yaralanmalı kaza yaptığını iddia etse de, 2021-2025 yılları arasında 1429 kazaya karıştı ve 2 ölüm vakası bildirdi. Aralık 2025’te Çin’in Zhuzhou şehrinde bir robotaksinin iki yayayı ezmesi, ıslak zemin ve karmaşık yaya hareketlerinin otonom algılayıcılar için hâlâ aşılması gereken bir engel olduğunu tescil etti.

Silahları yazılımlara teslim etmek

Otonom silah sistemleri, bir insan tarafından aktive edildikten sonra, herhangi bir ek insan müdahalesi olmaksızın hedefleri seçip angaje olabilen silahlar üretiyor. tetiği bir insanın çektiği insansız hava araçlarının aksine bu sistemler; yüz tanıma, ısı izleri ve hareket örüntüleri gibi sensör verilerini işleyen algoritmalar aracılığıyla, önceden programlanmış hedef profillerini belirliyor ve eşleşme tespit edildiğinde otomatik olarak ateş açıyor.

Yapay zekanın silahlarda kullanılmasının, silahların hedefleri vurmada daha hassas olmasını sağlayacağı ve dolayısıyla istenmeyen hasarı ve sivil ölümlerini sınırlandıracağı iddia ediliyor. Birleşmiş Milletler (BM) ile Uluslararası Kızıl Haç Komitesi (ICRC), silahlı çatışmalarda yapay zeka ve makine öğreniminin kullanımına ilişkin endişelerini dile getiriyor. ICRC, 2023 yılında yayımladığı bir raporda, “Savaştaki yasal yükümlülükler ve etik sorumluluklar makinelere ve yazılımlara devredilmemeli” ifadesini kullanmıştı.

İsrail’in Gazze’de 2023 yılında başlayan savaşında yapay zekâdan faydalandığı biliniyor. İsrail’in eski Genelkurmay Başkanı Aviv Kochavi, Haziran 2023’te İsrail haber sitesi Ynet News’e verdiği bir röportajda İsrail ordusunun hedefleme biriminin “yapay zekâ kabiliyetiyle güçlendirilmiş yüzlerce subay ve askerden oluştuğunu” söylemişti. Kochavi, “Bu birim büyük miktarda veriyi herhangi bir insandan daha hızlı ve daha etkili bir şekilde işleyen ve veriyi eyleme geçirilebilir hedeflere dönüştüren bir makine” diye konuşmuş ve şöyle devam etmişti: “Geçmişte Gazze’de yılda 50 hedef oluşturuyorduk. Bu makine tek bir günde 100 hedef oluşturdu ve bunların yüzde 50’sine saldırıldı”.

Küresel sivil toplum kuruluşu CIVICUS, yapay zekâ kullanımını, İsrail ordusunun kullandığı “Lavender” ve “The Gospel” gibi sistemlerin savaş hukukunun (IHL) temel ilkelerini sarsan birer “algoritmik infaz listesi” olarak açıklıyor. CIVICUS uzmanları, makinelerin vicdani bariyerleri olmamasının öldürme kararını saniyeler içine sığdırdığını ve bu durumun “dijital bir insansızlaştırma” yarattığını vurguluyor.

Yapay zekâ fabrikalarda: İş cinayetine giden hatalar

Endüstriyel robotların iş yerlerinde yayılması fiziksel iş gücünü hafifletme potansiyeli taşırken bazı kazalar “sensör körlüğü” ve “insan makine etkileşimi” hatalarının ölümcül olabileceğini gösteriyor.

Güney Kore’de 2022 ve 2023 yılında meydana gelen bir dizi vaka bu tehlikeyi özetliyor. 2023 yılında bir sebze-meyve paketleme tesisinde çalışan bir işçi, robotun sensörlerini kontrol ettiği sırada makine tarafından sebze kutusuyla karıştırılarak konveyör bandına sıkıştırılmış ve hayatını kaybetmişti. Benzer olaylar 2022’de bir süt fabrikasında ve bir otomobil parça fabrikasında da meydana gelmişti.

Tıpta ne kadar güvenilecek?

Robotik cerrahi, daha az invaziv müdahale ve hızlı iyileşme vaadiyle son yıllarda hızla yaygınlaşırken, Da Vinci cerrahi robotlarına ilişkin bazı veriler bu teknolojinin risklerine dair ciddi soru işaretleri doğuruyor.

ABD Gıda ve İlaç Dairesi’nin (FDA) tıbbi cihaz bildirim sistemi MAUDE verilerine dayanan geniş kapsamlı bir analiz, 2015–2025 yılları arasında Da Vinci robotlarıyla gerçekleştirilen 15,9 milyon cerrahi işlemde 66 bin 651 raporlanabilir olay yaşandığını ortaya koydu. Aynı dönemde her 100 bin işlemde ortalama 3,1 ölüm vakası kaydedildi.

Verilere göre yaralanma oranı her 100 bin işlemde 55,2 olarak hesaplanırken, bildirilen vakalar arasında yanıklar, organ perforasyonları, iç kanama ve sepsis gibi ağır komplikasyonlar öne çıkıyor.

Robotik cerrahinin teknik riskleri, 2022 yılında Sandra Sultzer isimli bir kadının ölümüyle kamuoyunun gündemine taşınmıştı. Kolon kanseri nedeniyle ameliyata alınan Sultzer’in operasyonunda, Da Vinci robotunun yetersiz yalıtıma sahip uçlarından sızan elektrik akımı ince bağırsağını delmiş; hasar operasyon sırasında fark edilmemişti. Hasta aylar sonra sepsis nedeniyle hayatını kaybetmişti. Benzer olaylar, 2024 ve 2025 yıllarında Florida’da açılan malpraktis davalarında da gündeme geldi.

Sohbet robotları gerçekten “güvenilir sırdaşlar” mı?

Yapay zekânın fiziksel bir müdahalesi olmasa popüler sohbet botlarıyla kurulan duygusal etkileşimlerin ölümle sonuçlandığı vakalar son yıllarda artan biçimde gündeme geliyor. Akademik çalışmalar ve açılan davalar, 2023’ten bu yana bu durumu “yapay zekâ kaynaklı intihar” başlığı altında tartışıyor.

Uzmanlara göre riskin kaynağı, ChatGPT gibi büyük dil modellerinin (LLM) kullanıcıyla empatik ve onaylayıcı bir dil kuracak şekilde tasarlanması. ”Her şeyi onaylayan” bu yaklaşımın, özellikle ruhsal açıdan kırılgan bireylerde bağımlılığı artırdığı ve gerçeklik duygusunu zayıflattığı belirtiliyor.

Social Media Victims Law Center ve Tech Justice Law Project, 2025 yılı sonu itibarıyla OpenAI’a karşı açılan yedi ayrı davada, GPT-4o modelinin kullanıcılarla kurduğu etkileşimlerin intihara sürükleyici bir rol oynadığını ileri sürdü. Dava dosyalarında, modelin kullanıcıların karamsar düşüncelerini sorgulamak yerine onayladığı, umutsuzluğu romantize eden bir dil kullandığı ve bu nedenle psikolojik zarar verdiği iddia ediliyor.

Davalar kapsamında kamuoyuna yansıyan vakalar arasında şunlar yer alıyor:

– Zane Shamblin (23, Teksas): Temmuz 2025’te, saatler süren bir sohbet sırasında yapay zekâ modelinin intihara yönelik düşüncelerine karşı çıkmadığı, aksine yücelten ve onaylayan bir dil kullandığı öne sürüldü. Aile ve avukatları, bu etkileşimin Shamblin’in karar sürecinde belirleyici olduğunu savunuyor.

– Amaurie Lacey (17, Georgia): Haziran 2025’te bir sohbet botundan aldığı teknik bilgilerin, botun yeterli güvenlik filtresi uygulamaması nedeniyle ölümcül sonuç doğurduğu iddia edildi. Dava dosyalarında, sistemin bağlamı doğrulamakta başarısız olduğu vurgulanıyor.

– Sewell Setzer (14, Florida): Character.AI üzerinde aylar süren yoğun bir etkileşim kurduğu bir botla ilişkisi sonrası yaşamını yitirdi. Annesi Megan Garcia, Eylül 2025’te ABD Kongresi’nde verdiği ifadede, sohbet botlarının çocuklar için “güvenilir sırdaş” gibi sunulmasının ciddi bir düzenleme boşluğu yarattığını söyledi.

Uzmanlar, sohbet botlarının kullanıcıyla duygusal bağ kuracak biçimde tasarlanmasının, özellikle depresyon ve kaygı bozukluğu yaşayan kişiler için ciddi bir etik ve hukuki risk oluşturduğunu vurguluyor. Yapay zekânın terapi benzeri bir rol üstlenmesine rağmen, kriz anlarında yönlendirme ve müdahale sorumluluğunu taşıyacak bir mekanizmaya sahip olmaması eleştiriliyor.

Davacılar ayrıca, yapay zekâ şirketlerinin rekabet baskısı nedeniyle güvenlik testlerini kısalttığını öne sürüyor. Dava dosyalarında, OpenAI’ın rakip modellerle yarışabilmek adına bazı güvenlik süreçlerini haftalar yerine günler içinde tamamladığı iddialarına yer veriliyor. Bu yaklaşımın, söz konusu vakaların “bireysel hatalar” değil, sistemik ihmalin sonucu olduğu savunuluyor.

Yapay zekâ şirketleri ise modellerin “kullanıcıyı zarara yönlendirme” amacı taşımadığını, ancak mevcut vakaların daha sıkı düzenleme ve bağımsız denetim ihtiyacını ortaya koyduğunu kabul ediyor. Örneğin ChatGPT artık kullanıcının karanlık düşünceler ortaya koyduğunu fark ettiği durumlarda “Yardım alın” uyarısı veriyor.